No entraremos en el debate de si es mejor ver una película o serie en versión original con subtítulos o doblada a otro idioma. Ambas opciones son respetables y complementarias, y los profesionales del doblaje no lo tienen fácil para cuadrar un texto en un idioma a unos actores que pronuncian otras palabras.

Precisamente, cuadrar la voz del doblaje con la imagen a doblar requiere de mucha pericia. De ahí que en ocasiones los guiones originales difieran de su traducción para que una palabra encaje con la boca del actor. Sin embargo, esto puede cambiar si empezamos a usar la tecnología disponible.

Y si hablamos de mover los labios en un vídeo, puede que te venga a la mente el concepto de deepfake. Por si no estás familiarizado, un deepfake es un vídeo manipulado de un famoso o político en el que éste dice algo que nunca dijo. Es decir, editas un vídeo cambiando sus palabras y el movimiento de sus labios. Según el software empleado, el resultado es prácticamente imperceptible.

Así pues, si usamos la tecnología ya disponible de edición de vídeo para crear deepfakes para un uso más ético y menos tóxico como es el doblaje de series o películas, el resultado será que podamos disfrutar de la ficción de cualquier país e idioma en nuestra propia lengua.

La inteligencia artificial en el doblaje

Obviamente, cuando hablamos de tecnología de manipulación de imágenes, es inevitable que surja el concepto de inteligencia artificial. Gracias a este campo tecnológico hemos sido capaces de avanzar rápidamente en el procesamiento de datos, imágenes y, ahora, de vídeos. Todo ello con ayuda de computadoras, software y los algoritmos adecuados. Sin presupuestos desorbitados como pudiera ocurrir en el pasado.

De software para crear deepfakes lo hay en abundancia y de lo más variado. En este artículo comenté varios de ellos, gratuitos y disponibles para smartphones y ordenadores personales.

Y desde India nos llega otra herramienta para la manipulación de vídeos empleando inteligencia artificial. Sus responsables son Prajwal Renukanand y el International Institute of Information Technology (Instituto Internacional de Tecnología de la Información), o más concretamente el Centre for Visual Information Technology que depende de éste. El propósito de su software: traducir vídeos en los que habla una persona.

La investigación que ha dado pie a este software está disponible para consultar libremente en inglés. En su página oficial se explica en qué consiste, qué hace y cómo lo hace. A partir de un vídeo cualquiera, la herramienta traduce el audio y, además, manipula la imagen para que no se note el cambio de idioma al hablar. Sincronización de labios de manera automatizada.

En el proyecto se ha trabajado con vídeos en inglés para traducirlos al hindi, pero se puede aplicar a cualquier otro idioma y tipo de vídeo. Las posibilidades son infinitas, como traducir programas informativos o documentales, eventos deportivos o, el ejemplo más claro, ficciones audiovisuales como series y películas.

Un proceso complejo que parece fácil

En el futuro, cuando este software esté implementado y disponible al público, el proceso será tan simple como pasar el vídeo y dejar que sus algoritmos realicen el trabajo duro. Pero como explican sus responsables, el proceso es más complicado de lo que vemos en pantalla.

Tal y como podemos ver en su página oficial, donde también está disponible el paper correspondiente, la traducción del vídeo consta de tres partes. La sincronización va aparte.

Primero, el software reconoce el idioma que debe traducir empleando DeepSpeech (para audios en inglés) y la API de Google para otros idiomas. La API de Google es conocida. Por su parte, DeepSpeech es una tecnología de reconocimiento que traduce audios a texto. Es de código abierto y emplea machine learning. Además, para facilitar su implementación emplea Google TensorFlow.

Una vez reconocido el texto hablado, la segunda fase consiste en traducirlo a otros idiomas. En el experimento se tradujo un texto en inglés a siete idiomas hablados en India.

Suscríbete a la newsletter diaria de Hipertextual. Recibe todos los días en tu correo lo más importante y lo más relevante de la tecnología, la ciencia y la cultura digital.

Y el tercer paso consiste en convertir de nuevo el texto traducido a audio. Para ello emplean DeepVoice para idiomas indios y Tacotron para inglés. Tacotron es un sistema de sintetizado de voz que convierte texto en audio y que es propiedad de Google.

En la práctica, se trata de combinar distintas tecnologías abiertas de reconocimiento de voz, traducción y sintentizado de voz para obtener una traducción de audio en condiciones. A partir de aquí, entra la parte de vídeo, es decir, adaptar el rostro de quien habla para que se adapte al nuevo audio sin que se note la manipulación del vídeo.

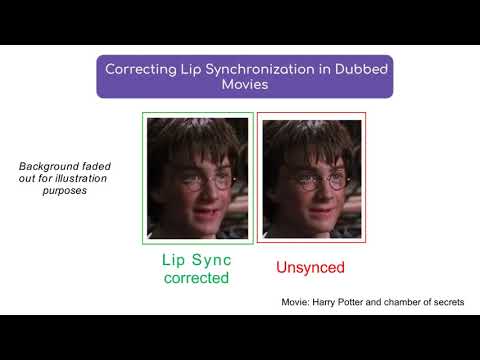

Y para este fin, los responsables de esta investigación han empleado LipGAN, su propio software de edición de vídeo especializada en traducir de manera automática los movimientos de los labios y las expresiones faciales. Lo mejor de todo es que el software está disponible con licencia abierta en su propio repositorio de GitHub.

Así, a partir de un fragmento de vídeo en el que una persona habla, LipGAN puede generar un vídeo equivalente adaptado al audio que hemos obtenido con las herramienta que mencioné antes.

Un futuro prometedor

El paper de nueve páginas de esta investigación explica algunas de las ventajas de aplicar machine learning. Esta rama de la inteligencia artificial hace posible que el propio software sea el encargado de discriminar los resultados poco satisfactorios. Además, hay que tener en cuenta la complejidad de sincronizar audio y vídeo, algo imposible hasta hace poco.

Aunque los resultados son satisfactorios, todavía queda trabajo por hacer. En cualquier caso, el software ahí está, a disponibilidad de quien quiera usarlo. Y como indican sus responsables, su utilidad es variada, tanto para el doblaje de películas como para crear material educativo en varios idiomas o para adaptar contenido televisivo como noticias o entrevistas.

En la actualidad encontramos, por separado o combinadas, tecnologías que permiten traducir texto. También transcribir audio a texto o generar audio a partir de un texto. El siguiente paso consiste en integrar ese audio en un vídeo. Era algo que tenía que llegar tarde o temprano. Y con LipGAN parece que ya hemos llegado a esa fase en la que el idioma hablado en un vídeo no tiene por qué ser un impedimento para que cualquiera pueda entenderlo sin necesidad de subtítulos.